ALS 患者中,约有 25% 的人患的是「延髓起病型」肌萎缩侧索硬化症,主要表现是说话障碍或吞咽困难 。这类病人说话会逐渐变得含糊、带有鼻音,甚至失语 。

Brunton 的行动很果断,确诊后马上找公司去做语音生成 。

来回花了一个月时间,录了 3000 多个句子的语料,但最后出来的结果并不理想 。

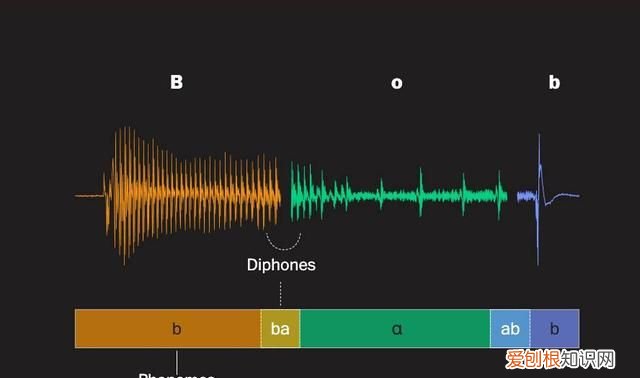

那家公司用的是一种名为「单元选择(unit selection)」技术 。

简单粗暴来说,它就是通过「拼接」来实现语音生成,把语料拆分为大量小的语音单元,然后按需把元素拼起来 。

文章插图

▲单元选择技术下,「Bob」这一词语能被拆分成不同语音元素,图自《华盛顿邮报》

这种技术生成的语音能听清,但会有点电音,听起来不太自然 。

结果就是,Brunton 录制的语料结合了微软一个名为「Heather」的声音,不但声音和自己毫不相似,甚至逼着这英国人「讲」起了美语口音 。

困在这个声音里,Brunton「只会在必要的时候说话,不再是因为想说话而说话」 。

从前和丈夫打闹聊天的心情消失了,Brunton 也不怎么愿意参加多人对话 。

即便是说「我爱你」,用一个不像自己的声音来说,意义也似乎被削弱了 。

文章插图

六个月后,Brunton 和丈夫争取回了最初录制的语音素材,找了另一家公司,用 AI 技术合成了一个更像她自己的声音:

这听起来也许有点傻,但重新获得自己的声音让我更有自信了 。在波士顿儿童医院负责「增强沟通」项目的 John M. Costello 留意到,那些采用了更真实生成语音的病人,似乎更能够和亲近的人建立深厚的联结 。

2022 年圣诞节,「重获新声」的 Brunton 还用语音录制的一段节日祝语 。

然而,圣诞刚过,Brunton 就染上了新冠,最后在今年 2 月离世了 。

她离开的那晚,丈夫 David 一整夜都握着她的手:

我们有两年时间来告别 。难以想象,如果 Brunton 后来没换上更像自己的声音,她又是否能自在地说出想说的一切 。

我们说好了,我们要说尽一切我们想说的 。

无障碍思维点亮灵感,AI 燃起生产力

文章插图

我一直认为,无障碍设计所挖掘的,其实就是人类多样性创造的想象力资源 。

我们去到和自己有着截然不同生活体验的人面前,聆听更少被诉说的故事和体验,创造出我们之前没想象过,但却能对更多人友好的的新生活方式 。

Personal Voice 能让失语的 ALS 患者重新获得自己的声音;也可以帮助在经历「刀片嗓」的我用自己的声音去和其他人对话;甚至,我也很难避免会去想象,是否应该用这为自己「备份」声音留给亲近的人,以免哪天自己会突然离世 。

而 AI 技术,就是实现这些想象力生产力 。

正如杜编辑之前说的,虽然不赶生成式 AI 的热闹,但苹果一直都把 AI 用来提升用户体验 —— 提升效率,保护隐私 。

文章插图

提升效率,在于提升本地执行的机器学习算法和模型 。

除了 Personal Voice 以外,苹果这次预览的另一个无障碍功能 Point and Speak 也采用了本地设备端的机器学习技术 。

未来,视障用户在 iPhone 自带的放大器里,结合 Point and Speak 和旁白功能,就能凭自己手指把 iPhone 变成「点读机」 —— 点到哪儿,让 iPhone 给你把文字读到哪儿 。

推荐阅读

- 秀米怎么样上传,秀米怎么放本地视频进去

- 安卓微信如何更新8.0 安卓微信如何更新8.0.6

- 海马汽车科技配置,有没有惊艳到你

- 大便后滴血怎么回事严重吗 大便出血但不痛怎么回事

- 山东艺术设计职业学院师生赴百花洲直播孵化基地参观学习

- 电脑桌面文件怎么随意摆放

- 圣诞送女生什么礼物好?送这款大眼橙小黄人H1绝对超值

- 为什么他不回我信息 不回我信息感觉你在爱

- 关于再也不信爱情的说说 不再相信爱情的说说